Apple ha puesto a prueba los chips de inteligencia artificial de Amazon para saber si son capaces de entrenar a sus modelos de lenguaje. La empresa de Cupertino reveló que están evaluando el nuevo chip Trainium2, desarrollado por Amazon, para tareas de pre entrenamiento de sus modelos propietarios. Apple añadió que las primeras pruebas ofrecieron resultados positivos en eficiencia.

De acuerdo con CNBC, Apple tuvo una participación importante durante la conferencia AWS Reinvent, organizada por Amazon Web Services. Benoit Dupin, director de aprendizaje automático e inteligencia artificial de Apple, reveló que la tecnológica utiliza la nube AWS para impulsar servicios como Siri o Apple Maps. No obstante, el anuncio que causó revuelo tiene que ver con los chips de inteligencia artificial desarrollados por Amazon.

Dupin declaró que Apple está en las primeras etapas de evaluación de Trainium2, un chip diseñado específicamente para admitir cargas de trabajo de IA generativa más grandes. El directivo añadió que los números tempranos arrojan un 50 % de mejora en la eficiencia con el entrenamiento previo.

La relación entre Apple y Amazon no es nueva. Dupin dijo que Apple se ha apoyado en AWS desde hace una década para potenciar sus servicios. De igual modo, la tecnológica echó mano de chips como Inferentia y Graviton para los servicios de búsqueda. Esto hace que el entrenamiento con Trainium2 sea un paso lógico para Apple, quien fue una de las primeras en probar el nuevo chip de Amazon.

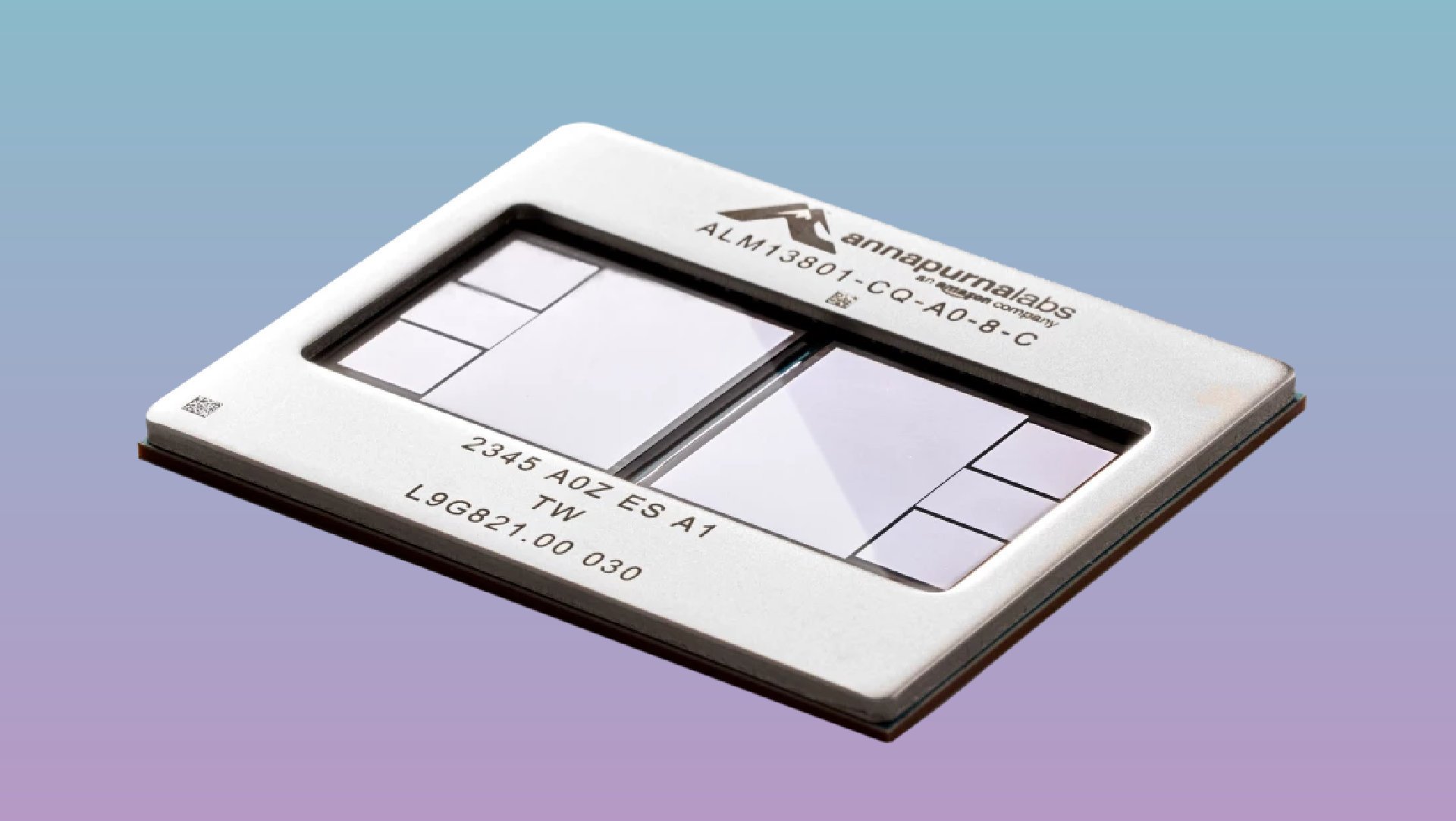

Así es Trainium2, el chip de Amazon que usa Apple para entrenar sus modelos de IA

El chip Trainium2 (Trn2) es una pieza de hardware diseñada específicamente para acelerar el entrenamiento de modelos de lenguaje de gran escala (LLM). De acuerdo con Amazon, Trainium2 utiliza una arquitectura basada en MPUs capaz de ejecutar eficientemente las operaciones matemáticas requeridas durante la fase de entrenamiento. El chip admite modelos con billones de parámetros y utiliza técnicas de bajo consumo que garantizan eficiencia energética.

«Trn2 ofrece una relación precio-rendimiento entre un 30 y un 40 % mejor que la generación actual de instancias EC2 basadas en GPU. Una sola instancia Trn2 combina 16 chips Trainium2 interconectados con una interconexión de chip a chip ultrarrápida de alto ancho de banda y baja latencia de NeuronLink para proporcionar 20,8 petaflops máximos de cómputo, ideal para entrenar e implementar modelos de miles de millones de parámetros de tamaño».

Apple no es la única que utiliza Trainium2 para el entrenamiento de modelos de IA. Amazon confirmó que cerró un acuerdo con Anthropic para utilizar los chips en Claude. La tecnológica reveló que está construyendo un clúster llamado Project Rainier, que ampliará el entrenamiento de Claude a través de cientos de miles de chips Trn2 interconectados con redes EFA.

El uso de Trainium2 para potenciar la IA de Apple no es algo descabellado. Sumado a la asociación con AWS, la tecnológica se ha apoyado en chips desarrollados por sus competidores. El ejemplo más evidente lo vemos con los procesadores de Google para entrenar la familia de modelos fundacionales de Apple.